Іграшки Mattel з штучним інтелектом: розвага чи цифрова загроза?

Світ Барбі чи Кошмар штучного інтелекту?

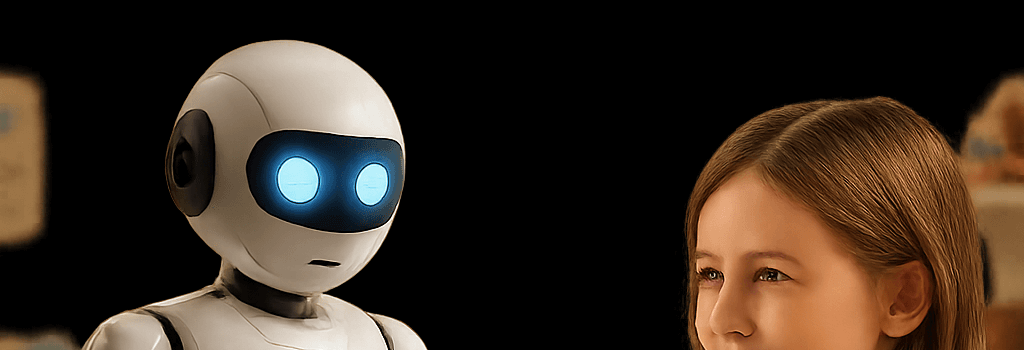

Після оголошення партнерства між Mattel та OpenAI, яке має на меті впровадження розмовного штучного інтелекту в дитячі іграшки, споживчі активісти та технічні експерти забили тривогу щодо можливих ризиків для розвитку, конфіденційності та безпеки. У той час як Mattel анонсує лінійки Барбі та Hot Wheels з елементами штучного інтелекту, багато батьків та регуляторів вимагають чітких відповідей про функціонування цих “розумних” іграшок, обробку даних та запобіжні заходи.

Проблеми прозорості та безпеки, підняті Public Citizen

17 червня 2025 року співпрезидент Public Citizen Роберт Вайсман оприлюднив заяву, в якій закликав Mattel розкрити принципи дизайну іграшок з AI до початку продажу продукції. Вайсман попередив:

Надання іграшкам людських голосів, які ведуть вільні розмови, може суттєво зашкодити соціальному розвитку дітей та їхній уяві. Іграшки, що спілкуються як однолітки, можуть підривати реальні стосунки та викликати плутанину між реальністю та грою.

Вайсман також закликав Mattel встановити чіткі межі, зокрема заборонити використання AI для дітей молодше 13 років, а також зобов’язатися до незалежних перевірок безпеки та конфіденційності.

Публічні заяви Mattel та OpenAI

У спільному прес-релізі Mattel та OpenAI навмисно залишилися неясними:

Ми будемо підтримувати продукти та досвід на основі знакових брендів Mattel, перший реліз буде оголошено до кінця року, а повний запуск очікується в 2026 році.

Обидві компанії стверджують, що дотримуватимуться всіх вимог COPPA (Закон про захист конфіденційності дітей в Інтернеті) та GDPR, впроваджуватимуть фільтри контенту за віком і пріоритетно оброблятимуть дані. Однак жодних конкретних технічних деталей, наприклад, чи відбувається обробка природної мови в хмарі чи на краю мережі, не було розкрито.

Технічна архітектура іграшок на основі AI

Експерти галузі вважають, що іграшки з AI поєднуватимуть вбудований мікроконтролер ARM Cortex-A7 з модулем Wi-Fi або Bluetooth LE для підключення до хмари. Ключові компоненти включають:

- Розуміння природної мови (NLU): Голосові команди захоплюються за допомогою MEMS-мікрофона, оцифровуються на 16 біт/16 кГц і передаються через TLS 1.3 на моделі класу GPT-4, що працюють на серверах OpenAI.

- Генерація природної мови (NLG): Відповіді формуються з контекстом до 32 тисяч токенів, що дозволяє вести багаточасові розмови, але також підвищує затримку та вимоги до пропускної здатності.

- Кеш на пристрої: Локальна база даних SQLite може зберігати очищені журнали взаємодії для офлайн-відтворення, що вимагає надійного шифрування (AES-256) та безпечного управління ключами.

Цільова затримка менше 300 мс буде критично важливою для підтримки потоку розмови, але реальні умови Wi-Fi можуть викликати затримки, що можуть порушити ігровий процес.

Регуляторний ландшафт та відповідність

Розумні іграшки, що збирають голосові та поведінкові дані від дітей молодше 13 років, підпадають під COPPA. Mattel повинна отримати підтверджену згоду батьків:

- Розкрити, які категорії даних збираються.

- Надати батькам право переглядати або видаляти дані своїх дітей.

- Впровадити перевірку віку та дотримуватися власної політики OpenAI, що забороняє використання для дітей до 13 років.

Окрім того, глобальні регуляції, такі як GDPR-K (дитяча розширена версія GDPR) та CCPA Каліфорнії, накладають додаткові вимоги до прозорості та мінімізації даних. Невиконання цих вимог може призвести до штрафів до 4% світового доходу.

Контроль безпеки даних та конфіденційності

Експерти рекомендують кілька найкращих практик:

- Шифрування з кінця в кінець: Використовувати TLS 1.3 з досконалою попередньою секретністю для всіх обмінів голосом і токенами.

- Панель управління для батьків: Додаток для мобільних пристроїв повинен дозволяти батькам додавати теми до білого списку, встановлювати добові ліміти на взаємодію та очищати збережені журнали.

- Незалежні аудити: Залучати сторонні компанії з безпеки (наприклад, CyberAB або CURE53) для періодичного тестування на проникнення та оцінки впливу на конфіденційність.

Думки експертів про ризики та вигоди

На LinkedIn етичний експерт у сфері AI Варундіп Каур підкреслила потенційні вигоди, такі як персоналізоване вивчення мови, але попередила про приховані упередження у великих мовних моделях, які можуть відтворювати стереотипи або культурно нечутливий контент. Спеціаліст з кібербезпеки Адам Додж з EndTab вказав на задокументовані випадки, коли чат-боти ненавмисно заохочували самопошкодження, підкреслюючи необхідність суворого фільтрування контенту та перевірки взаємодій з людським контролем.

Судові справи та питання інтелектуальної власності

Окрім благополуччя дітей, Mattel може зіткнутися з потенційними суперечками щодо авторських прав. Голлівудські студії нещодавно подали позов до AI-генератора зображень за несанкціоноване використання образів персонажів. Аналогічно, AI-Барбі, яка відтворює зареєстровані слогани чи фрази без ліцензії, може призвести до витратних судових розглядів. Mattel повинна впевнитися, що її набори для доопрацювання виключають матеріали, захищені авторським правом, без ліцензії.

Перспективи майбутнього та найкращі практики для ігор з AI

Щоб сприяти довірі суспільства та безпечному впровадженню, учасники галузі рекомендують:

- Опублікувати Хартію відповідальних іграшок з AI, що включає етичні норми, пороги безпеки та показники ефективності.

- Залучати психологів дитячого розвитку на ранніх стадіях дизайну для оцінки соціальних та когнітивних впливів.

- Співпрацювати з регуляторами, такими як Федеральна торгова комісія, для впровадження добровільних програм сертифікації.

Хоча перспектива інтерактивної, навчальної гри є привабливою, Mattel та OpenAI повинні уникати поспіху на ринок без надійних технічних та політичних запобіжників. Наступні місяці покажуть, чи стане ця співпраця прикладом відповідального використання AI в іграшках, чи ж попередженням про те, як інновації можуть випереджати контроль.